缘之空安卓版汉化

1435MB · 2025-12-24

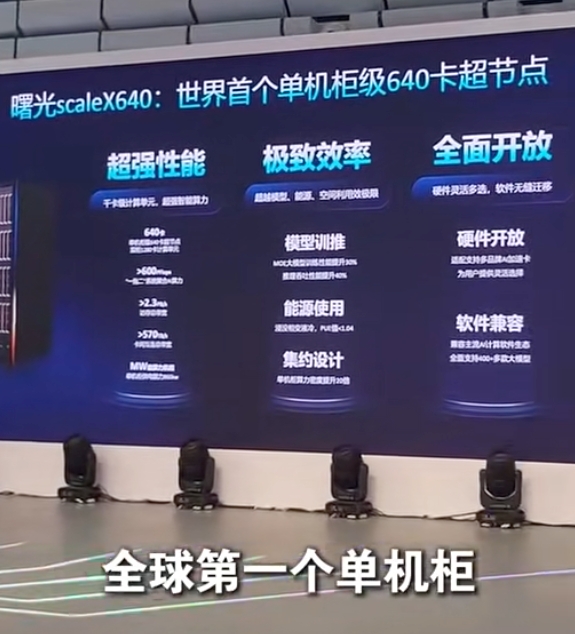

单机柜 640 卡设计:采用 “一拖二” 高密架构,实现 640 张加速卡超高速总线互连,构建大规模、高带宽、低时延的通信域。双超节点可组成千卡级计算单元,支持万亿参数大模型训练,显著提升训练效率和推理速度。

系统级工程创新:算、存、网、电、冷一体化紧耦合设计,融合超高速正交架构、浸没相变液冷、高压直流供电等技术,单机柜算力密度较业界提升 20 倍,PUE 降至 1.04-1.1,能耗比显著优化。

开放架构与生态兼容:硬件支持多品牌加速卡,软件兼容主流 AI 框架(如 TensorFlow、PyTorch)和 CUDA 生态,降低企业软件迁移成本 60% 以上,推动 AI 算力从 “昂贵资源” 转变为 “普惠基础设施”。

行业应用加速:已应用于生物医药、港口调度、新材料研发等领域,缩短科研周期和成本。例如,新冠病毒变异蛋白预测周期从 15 天缩短至 7 天,基因测序单样本分析时间压缩至 24 小时,新材料研发周期缩短至 6 个月。

国产化进程关键突破:解决高端芯片算力不足、标准缺失、软硬件割裂等问题,推动国产智算从 “单点突围” 走向 “生态共进”。

全球算力竞争新范式:以开放架构和系统创新,推动 AI 算力生态从 “垂直整合” 转向 “开放兼容”,助力中国在全球智能竞争中构建自主可控、开放共赢的算力新生态。

支持大规模集群扩展:经过 30 天以上长稳测试,可扩展至 10 万卡级超大规模集群,保障 AI 算力的高可靠性和可扩展性。

降低 AI 算力成本:通过高密设计和能耗优化,降低 AI 算力的部署和运营成本,推动 AI 技术在更多行业的普及和应用。

scaleX640 超节点通过高性能、开放生态和系统创新,推动 AI 算力从 “可用” 到 “好用”,加速 AI 大模型训练和行业应用落地,助力中国在全球 AI 算力竞争中实现弯道超车。