小马爱学

131.57MB · 2025-12-17

最近几天,Google 的 Nano banana 模型 刷爆了各大技术社区。本着紧跟技术发展的思路,我们也来探讨一下:这项新模型的突破点究竟在哪里,它是否可能为前端交互带来新的可能性?

在过去的图像生成模型中,大家对其“创意性”和“美感”印象深刻,但控制力一直是短板:

因此,尽管图像生成已经在创意和效率方面提升了生产力,但距离大规模商用始终有一段距离。相比之下,前端页面使用代码渲染的原因正是:精确度高、可控性强,能够保证组件和布局严格符合需求。

而这一次,Nano banana 模型在控制力上实现了质的飞跃。它能更自然地修改图像、保持角色一致性,并对局部区域进行精确控制。这种 “可控与可编辑” 的特性,让它离实际商用、甚至改变部分前端渲染方式,又近了一步。

接下来,我们先看它的生成效果,再简单理解它的原理,最后谈谈我对未来交互的展望。

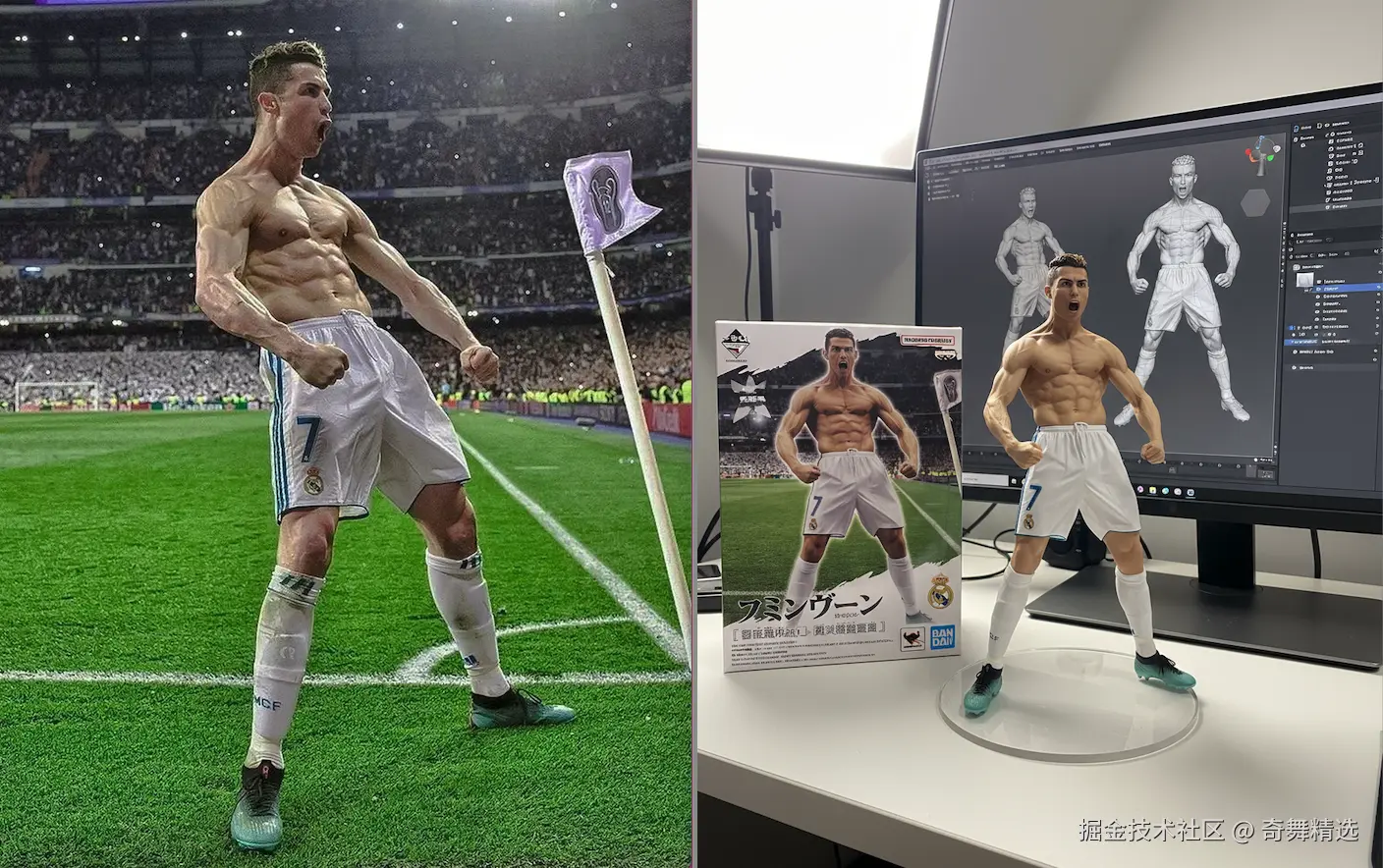

最近最火的玩法就是 照片转手办。我亲自测试了,结果让我非常震撼——图像前后结构高度一致,生成效果几乎媲美实物建模。

提示词

Using the nano-banana model, a commercial 1/7 scale figurine of the characterin the picture was created, depicting a realistic style and a realistic environment. The figurine is placed on a computer desk with a round transparent acrylic base. There isnotexton the base. The computer screen shows the Zbrush modeling process of the figurine. Next to the computer screen is a BANDAI-style toy boxwith the original painting printed on it.

除此之外,网上也有不少惊艳的案例:

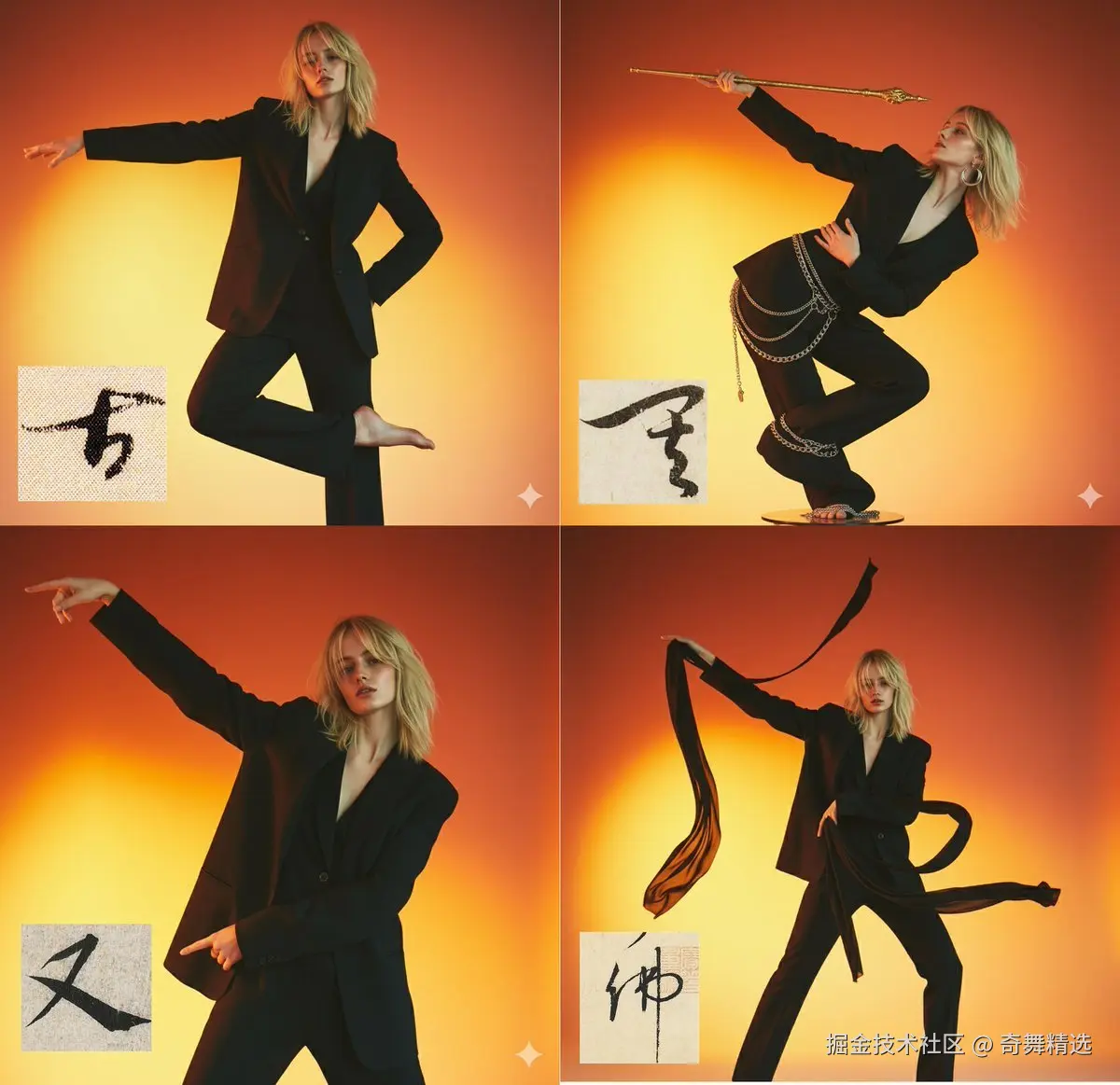

引用 x.com/op7418/stat…

将简单的简笔画(火柴人)作为动作草图,结合指定的人物形象,生成具有相同动态的、细节丰富的动漫场景。

引用 x.com/yachimat_ma…

让它创建一张有人直视的照片

引用 x.com/arrakis_ai/…

多场景一致性

它只修复需要修改的部分,同时保持所有图像的其他部分一致。

引用 x.com/azed_ai/sta…

再来看一组多模型对比。

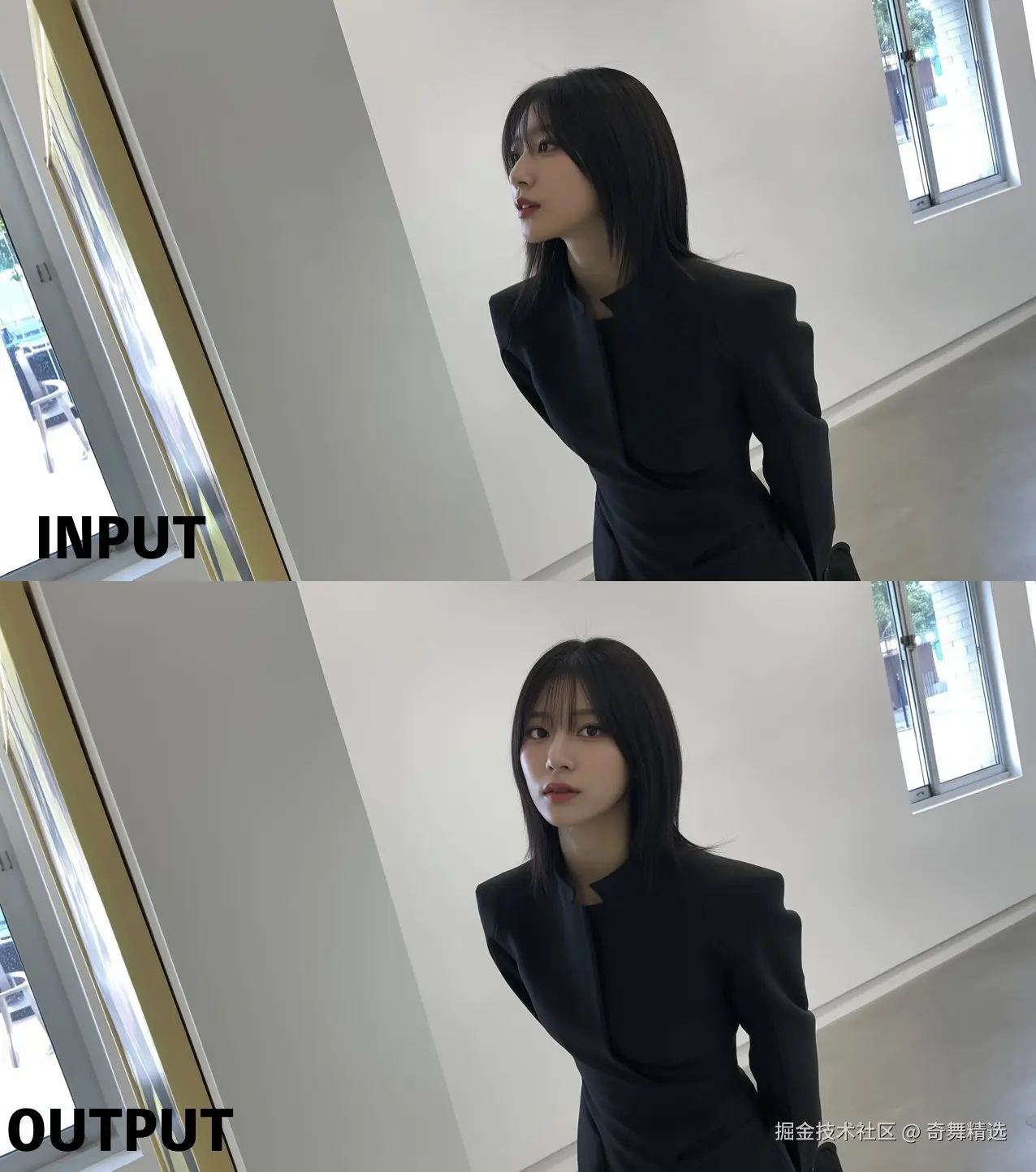

原始图片如下:

提示词为:Transform everything into a cartoon style except for the girl’s face and body。

( 意思是除了女生的脸和身体外,将其他东西都转成卡通风格 )

各个模型的生成效果如下:

引用 waytoagi.feishu.cn/wiki/IffFw8…

可以看出,只有 Nano banana 在保持人脸一致性方面表现最好。虽然手部略有偏差,但整体保真度、局部控制力已经远超其他模型。

这说明:Nano banana 在图像理解和控制上的进步,正在把“随机生成”推进到“可控生成”。

从上面的这些案例可以看出可以看出Nano Banana在图像理解和控制能力方法有了很大的进步。完美的控制力再加上想象力,会对图像处理领域产生很大的影响,并且以后也许会改变很多前端的交互和渲染方式。接下来我们来看一下这个模型的控制力是怎么变得如此强大的。

据 DeepMind 的研究员介绍,Nano banana 模型是基于 Gemini 2.5 Flash 的“原生图像生成模型”的一次升级。与传统生成模型相比,它的突破点在于:不仅能“生成更好看”,更能“生成可控、可编辑”的结果。

传统的图像生成模型通常是“一步到位”的:输入提示词 → 输出一张图。这样做的问题是:

而 Nano banana 引入了“交错式生成”范式。

这相当于给生成过程加了一条“带状态的轨道”。复杂的修改任务不再需要一个庞杂的指令,而是自然地拆解为多个小步骤。这样既减少了细节丢失和冲突,又大大提升了图像编辑的一致性。

Gemini 2.5 Flash 的另一个核心升级,是把 图像生成、理解与编辑纳入同一多模态上下文。

这使得模型不仅会“画”,还会“懂”,从而具备了对局部修改、保持整体一致性等更强的控制力。

Nano banana 的训练体系也有新的设计:

DeepMind 团队在未来优化方向上提出了两条主线:

此外,团队还在探索“个性化审美打分器”:让模型逐步学习并匹配用户的审美倾向。未来这可能成为一种交互方式:用户不再需要细致描述风格,而是由模型自动理解并生成符合“你个人审美标准”的内容。

总结一句话: Nano banana 的本质突破,是把“生成”和“理解”合并在一条轨道上,让图像生成从一次性结果转变为连续可控的过程。 这不仅解决了过去“随机性太高”的问题,也为它在前端交互和实际商用中的应用奠定了基础。

设想未来的一个场景:

在这种模式下,前端开发可能从 “代码驱动的渲染” 逐渐演变为 “模型驱动的渲染”。

这并不意味着代码会被彻底取代,而是提供了一个新的思路:依赖模型的控制力,来塑造更自然、更智能的交互体验。如果未来控制精度继续提升,前端的形态或许会迎来一次真正的革新。

Nano banana 模型标志着图像生成从 “好看” 走向 “可控” 的关键一步。 它不仅让我们看到了 AI 在图像处理上的商用前景,也让人开始畅想:在前端交互中,是否会出现这样一种新模式-从 代码驱动的交互,走向 模型驱动的交互。

这也许正是值得我们观察、尝试和思考的方向。

参考

x.com/op7418/stat…

waytoagi.feishu.cn/wiki/RuGMwH…

www.youtube.com/watch?v=H6Z…

waytoagi.feishu.cn/wiki/IffFw8…